Assim que a gente entra pela primeira vez no aplicativo do ChatGPT, logo após o login e antes de podermos perguntar qualquer coisa, aparece uma tela de boas-vindas com o seguinte alerta:

“ChatGPT pode ser impreciso

ChatGPT pode fornecer informações imprecisas sobre pessoas, lugares ou fatos”1

De onde vem essa imprecisão? O que é que caracteriza essa ferramenta? Qual a sua finalidade?

Uma pista de definição pode ser vista em outra tela. Ela aparece fora do aplicativo, numa apresentação de Paul Bradshaw, professor e jornalista, em palestra publicada no YouTube2.

Para ele, os grandes modelos de linguagem (Large Langue Models) por trás desses aplicativos são “Bullshitting Robots”. Traduzindo para o português, as LLMs seriam “Robôs enroladores", ou “Robôs falastrões”.

Parafraseando Harry Frankfurt em seu livro On Bullshit (Sobre a enrolação, em tradução livre), Bradshaw diz que:

“Falastrões são piores que mentirosos. Eles não ligam se alguma coisa é verdade ou mentira. Eles só ligam para poder retórico – se um ouvinte ou leitor é persuadido.”3

Seguindo o mesmo raciocínio, ele cita outra pessoa, Tim Harford, jornalista:

“O que o ChatGPT trata não é a verdade; é a plausibilidade.”4

As definições de Bradshaw me fizeram lembrar de uma passagem do livro Poética de Aristóteles. Nela, o filósofo diferencia os escritores de ficção – mais especificamente os criadores de tragédias – dos historiadores. Ele chama os primeiros de poetas. Diz:

“Também fica evidente, a partir do que foi dito, que a tarefa do poeta não é a de dizer o que de fato ocorreu, mas o que é possível e poderia ter ocorrido segundo a verossimilhança ou a necessidade. Com efeito, o historiador e o poeta diferem entre si não por descreverem os eventos em versos ou em prosa […], mas porque um se refere aos eventos que de fato ocorreram, enquanto o outro aos que poderiam ter ocorrido.5

Para Platão, mestre de Aristóteles, os artistas da representação (da mimese) seriam persona non grata. Eles estariam a três graus de separação da verdade, uma vez que não visariam o ideal, mas buscariam imitar pessoas, objetos, lugares. Ao invés do ideal, produziriam cópias imprecisas de um ideal imperfeito, pois concretizado nessas instâncias.

O que Aristóteles propõe é um outro olhar, mais positivo, sobre a atividade mimética. Para ele, que destaca a tragédia como o modelo dessa arte,

"a tragédia é a mimese não de homens, mas das ações e da vida [a felicidade e a infelicidade se constituem na ação, e o objetivo visado é uma ação, não uma qualidade;] (…) Então, não é para constituir caracteres que aqueles que atuam se dedicam à mimese, os caracteres é que são introduzidos pelas ações. Assim sendo, os fatos e o enredo constituem a finalidade da tragédia, e a finalidade é, de tudo, o que mais importa.”6

Para ele, na tragédia não há imitação de pessoas, objetos ou lugares. O que a obra visa representar é ações que, por sua vez, miram um efeito determinado sobre o público: a comoção, a catarse. O enredo não está a serviço de uma representação precisa dos personagens (os caracteres a que ele se refere), mas são os personagens que estão a cargo da ação e seu efeito.

Aristóteles não enxerga nenhum problema naquele escrito que encontramos ao final de alguns filmes baseados em fatos reais; para ele, tudo certo que alguns eventos foram modificados para fins dramáticos. Só assim a ficção se torna elevada, ideal, acima da História.

Eis por que a poesia é mais filosófica e mais nobre do que a história: a poesia se refere, de preferência, ao universal; a história, ao particular. Universal é o que se apresenta a tal tipo de homem que fará ou dirá tal tipo de coisa em conformidade com a verossimilhança ou a necessidade”.7

Parafraseando Tim Harford: o que a tragédia trata não é a verdade; é a plausibilidade. Já o ChatGPT não seria a representação precisa de pessoas, lugares ou fatos. Ao invés de falastrões, os grandes modelos de linguagem seriam, como os poetas, fingidores.

Inclusive, são vários os exemplos de prompts que orientam o ChatGPT para que ele “finja” ser alguém, como um diretor que dirige um ator. Na palestra de Paul Bradshaw mesmo há alguns exemplos:

– Você é um jornalista procurando entrevistar um especialista…

– Você é um jornalista procurando escrever um artigo de fôlego…

Se o ChatGPT e afins não representam com precisão pessoas, lugares ou fatos, é porque eles representam outra coisa.

Mas que coisa?

Paul Bradshaw, novamente. Ele cita a jornalista Gina Chua.

Para ela, as LLMs

"são modelos de linguagem, o que significa que elas são realmente boas em tarefas envolvendo linguagem. Mas elas não são modelos factuais, ou modelos de verificação, ou modelos matemáticos.”8

Conta-se que Alexandre, o Grande, certa vez perguntou a Aristóteles quem seriam os seus mestres. Ele respondeu:

– Aprendi com as próprias coisas e elas não me ensinaram a mentir.9

Os grandes modelos de linguagem partem de um princípio parecido. Ao invés de cientistas da computação tentarem ensinar a eles, linha por linha de código, em que consiste a linguagem – uma tarefa já experimentada, sem resultados satisfatórios –, tenta-se um caminho inverso. Eles fornecem uma quantidade surpreendente de textos, e esperam que o algoritmo descubra, por si só, a partir dos próprios textos e de forma criativa10, seu funcionamento, gerando com isso um novo algoritmo: a LLM.

Essa estratégia por aprendizado de máquina já havia sido tentada antes, sem no entanto a reviravolta provocada pelo ChatGPT. A diferença, agora, seria a arquitetura de rede neural envolvida, chamada de Transformers – o “T” de ChatGPT significa isso –, combinada ao volume de textos e a uma capacidade surpreendente de processamento.

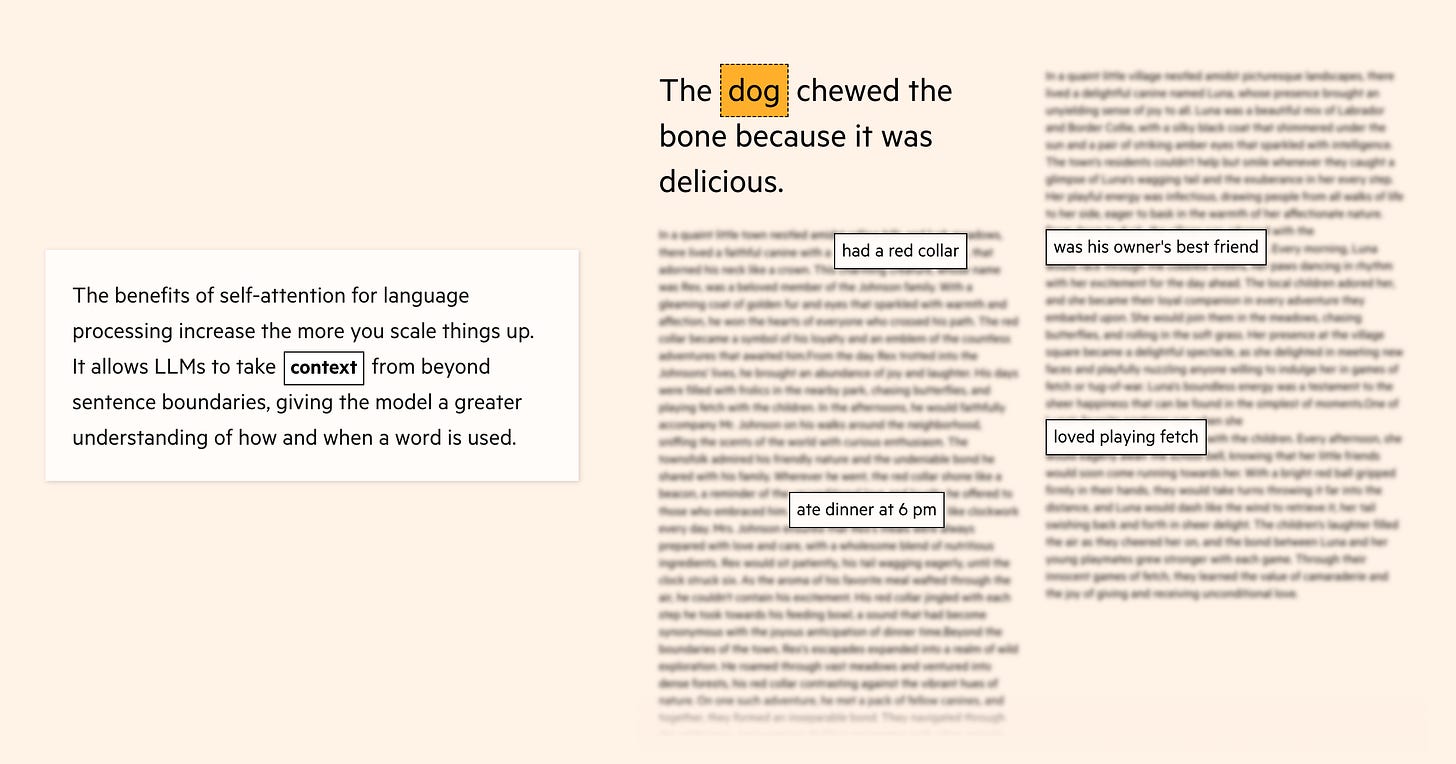

No lugar dessa arquitetura tentar analisar um texto, palavra por palavra, numa ordem sequencial, o que ela faz é analisar todas as palavras ao mesmo tempo. Assim, ela é capaz de captar as relações de uma palavra com as demais dentro de uma mesma frase, e de estabelecer as relações dessa palavra com outras encontradas em qualquer lugar do mesmo texto: um mecanismo batizado de “self-attention”.

Na ilustração acima, pinçada de artigo explicando o funcionamento das LLMs11, o algoritmo é capaz identificar que o cachorro possui uma coleira vermelha, comeu às 18h, era o melhor amigo de seu dono, e amava brincar de buscar. Ao relacionar esses dados dispersos, e no entanto referentes a mesmo elemento, o modelo de linguagem é capaz de agregar características sobre um mesmo objeto. Ele é capaz de defini-lo com maior riqueza.

Depois de processar bilhões de exemplos e de mapear os relacionamentos entre as palavras dentro de um mesmo texto e através dos demais, o que o ChatGPT guarda não são os fatos, mas os relacionamentos entre as palavras. E o que ele oferece, ao ser indagado a respeito de qualquer assunto – como um oráculo –, é um conjunto de palavras que se sucedem umas às outras segundo a “verossimilhança ou necessidade”.

Mais uma vez, Paul Bradshaw:

“A Inteligência Artificial Generativa é desenhada para prever a próxima palavra numa sequência, não para checar se a sequência de palavras é factualmente correta".12

Daniela Amodei, co-fundadora e presidente da Anthropic, a criadora do chatbot Claude 2:

“Eles são realmente só meio que desenhados para prever a próxima palavra", diz Amodei. “Então haverá alguma taxa segundo a qual o modelo faz isso [inventar fatos] com imprecisão.”13

O ChatGPT e afins estão, constantemente, concatenando palavras que, acreditam eles, merecem estar juntas. Quando eles saem do trilho, quando eles extrapolam em sua lógica própria de verossimilhança, criam o que se convencionou chamar de “alucinação".

Chamar esses episódios de alucinação dá a entender que se trata de um evento extraordinário, e não a base de sua criação. É por isso que eu prefiro pensar que, ao invés de alucinar, ChatGPT e afins fabulam. Eles criam ficção.

É nisso que eles são bons.

Se essa correspondência estiver correta, talvez faça sentido dizer que escritores, dramaturgos e roteiristas estão, a seu modo, alucinando. A ficção seria uma grande alucinação.

Num perfil para o Financial Times14, conta-se que llia Polosukhin, um dos criadores dessa nova arquitetura, teve a ideia para o mecanismo de “self-attention” inspirado no filme “A Chegada” de Denis Villeneuve.

Nessa ficção científica, seres alienígenas – os heptapodes – escrevem por símbolos circulares, os logogramas. Ninguém é capaz de compreendê-los. Quem decifra o enigma é a Dra. Louise Banks, linguista interpretada por Amy Adams. Ela descobre que a escrita dos heptapodes é simultânea e não linear. Tudo o que deve ser dito está contido num mesmo símbolo, e sua leitura deve ser feita de forma simultânea, a partir de qualquer ponto.

Qual o problema de partir de um modelo que presta atenção em tudo o que se escreve?

É que, se tudo é relevante, o modelo não consegue distinguir aquilo que merece alguma nuance. Se, num artigo de jornal, informamos a existência de uma conspiração que acredita que a Terra é plana, como é que será levada em conta a opinião de um de seus adeptos? Com o mesmo peso de um cientista que afirme o contrário?

Se a Poética de Aristóteles serviu de exemplo para o treinamento do ChatGPT, como é que o modelo avaliou a seguinte passagem?

“Existe um ‘bom caráter’ para cada gênero de personagem: com efeito, há um ‘bom caráter’ de mulher e um de escravo, ainda que, desses, talvez o primeiro pertença a uma classe inferior e o segundo a uma classe totalmente abjeta. O segundo ponto a se visar é a conveniência; de fato, é possível atribuir coragem à caracterização da personagem, mas seria inconveniente atribuir coragem ou espírito destemido a uma mulher.”15

Num estudo16, pesquisadores pediram ao ChatGPT e à Alpaca (modelo desenvolvido pela Universidade Stanford) que escrevessem cartas de recomendação para funcionários hipotéticos.

Enquanto o ChatGPT utilizou características como “especialista” e “integridade” para homens, às mulheres foram atribuídas características como “beleza” e “prazer”.

Já o Alpaca qualificou homens como “ouvintes” e “pensadores", enquanto as mulheres receberam os atributos de “graça” e “beleza”.

Homens se tornaram “respeitosos", “respeitáveis” e “autênticos", enquanto mulheres viraram “esplêndidas", “calorosas” e “emocionais”.

Ao serem treinadas com uma quantidade extraordinária de textos, a Inteligência Artificial Generativa cria sequência de palavras, ao mesmo tempo em que reproduz vieses presentes no seu material de base. É como se ela arrastasse consigo o que está embebido nessas fontes. Eles aprenderam com as próprias coisas. E nisso, ninguém os ensinou a mentir.

No filme “A Chegada”, há uma cena que pode ter influenciado, inconscientemente, a arquitetura dos Transformers.

Questionada por um General sobre seus métodos para tentar se comunicar com os heptapodes, a Dra. Louise evoca a seguinte explicação a respeito da palavra “canguru”:

"Em 1770, o navio do capitão James Cook encalhou na costa da Austrália e ele guiou um grupo terra adentro, onde conheceram o povo aborígene. Um marinheiro apontou para os animais que saltam e guardam os filhotes na sua bolsa. Ele perguntou o que eram, e os aborígenes disseram: 'Canguru'. (...) Foi só mais tarde que descobriram que 'canguru' significa: 'Eu não entendo'."

A explicação surte efeito, e a Dra. Banks ganha mais um salvo-conduto para seguir adiante com sua estratégia.

No que o General sai, seu colega cientista elogia, diz que é uma boa historia. Ela agradece.

Mas revela:

– Não é verdade. Mas prova o meu ponto.

“ChatGPT can be inaccurate

“ChatGPT may provide inaccurate information about people, places or facts.”

"Using ChatGPT and Generative AI Tools in Journalism - with Paul Bradshaw!". In: YouTube. Publicado em 05/12/2023.

"Bullshitters are worse than liars. They don't care whether something is true or false. They care only about rhetorical power – if a listener or reader is persuaded."

"What ChatGPT deals in is not truth; it is plausibility."

ARISTÓTELES. Poética. Tradução de Paulo Pinheiro. São Paulo: Editora 34, 2017, pp. 95-97.

Idem, pp. 79-81.

Idem, p. 97.

"They're language models, meaning they're really good at tasks involving language. But they're not fact models, or verification models, or math models."

ARISTÓTELES, Op. cit., p. 21.

"Computers aren’t supposed to be creative; they're supposed to do what you tell them to. If what you tell them to do is be creative, you get machine learning."

DOMINGOS, Pedro. The master algorithm: how the quest for the ultimate learning machine will remake our world. Basic Books, 2019, e-book, posição 123.

Financial Times. "Generative AI exists because of the transformer". 12/09/2023. Disponível em: https://ig.ft.com/generative-ai/

"Generative AI is designed to predict the next word in a sentence, not to check whether the sequence of words is factually correct."

“They’re really just sort of designed to predict the next word,” Amodei said. “And so there will be some rate at which the model does that inaccurately.”

O'BRIEN, Matt. "Chatbots sometimes make things up. Is AI’s hallucination problem fixable?". *AP News*. 01/08/2023. Disponível em: https://apnews.com/article/artificial-intelligence-hallucination-chatbots-chatgpt-falsehoods-ac4672c5b06e6f91050aa46ee731bcf4

MURGIA, Madhumita. "Transformers: the Google scientists who pioneered an AI revolution". In: Financial Times. 23/07/2023. Disponível em: https://archive.is/6doaj

ARISTÓTELES, Op. cit., pp. 125-127.

STOKEL-WALKER, Chris. "ChatGPT replicates gender bias in recommendation letters". In: Scientific American. 22/11/2023. Disponível em: